Automatische Spracherkennung in der Logopädie

Veröffentlicht am |

Wie zuverlässig sind ASR-Systeme* in der Aphasietherapie?

*ASR = Automatic Speech Recognition

Das haben wir uns natürlich zu Beginn der Konzeption und Entwicklung der Benenn-App LingoTalk gefragt. Können wir es wagen, ein Plug-In für die automatische Spracherkennung (ASR) einzubauen?

In der täglichen Arbeit mit meinen schwerbetroffenen jungen Schlaganfallpatient*innen habe ich vorher schon oft speech to text-Programme eingesetzt, um die Aussprache zu trainieren. Das habe ich getan, weil ich einen „unabhängigen Experten“ gesucht habe, der sich nicht – wie ich – voll und ganz in die sprechmotorischen Besonderheiten meines Gegenübers eingehört hat.

Im Laufe der Jahre konnte ich beobachten, wie die Systeme immer besser und treffsicherer wurden. So entstand die Idee, bei LingoTalk ein Plug-In für die Spracherkennung einzubauen. So erfahren Betroffene auch unabhängig von der Therapeutin, ob sie das Wort richtig gesprochen haben.

Wie gut arbeiten aber unsere Systeme? Das wir in Zusammenarbeit mit dem Studiengang Rehabilitationswissenschaften der Humboldt-Universität zu Berlin in einer systematisch kontrollierten Erhebung untersuchen. Eine erste Stichprobe an 10 sprachgesunden Teilnehmenden hat vielversprechende Ergebnisse gezeigt. Die Sprecher:innen waren zwischen 20 und 70 Jahre alt und kamen aus dem Berliner und Hamburger Raum. Sechs Männer und vier Frauen haben an dem Experiment teilgenommen.

Im Abstand von ca. einer Woche wurden die Proband:innen gebeten, 50 Begriffe aus der Lingo-Datenbank zu benennen. Dabei wurden auch bei den gesunden Sprecher:innen nicht alle Begriffe beim ersten Anlauf korrekt benannt. In LingoTalk gibt es drei Versuche, bevor der Begriff aufgelöst wird und zum nächsten Item übergegangen wird. So kamen insgesamt 1801 Sprachaufnahmen zusammen, die im Anschluss im Hinblick auf ihre Zuverlässigkeit der Reaktion (richtig/nicht erkannt) ausgewertet wurden. Vergleichskriterium war das menschliche Ohr von zwei erfahrenen Sprachtherapeutinnen.

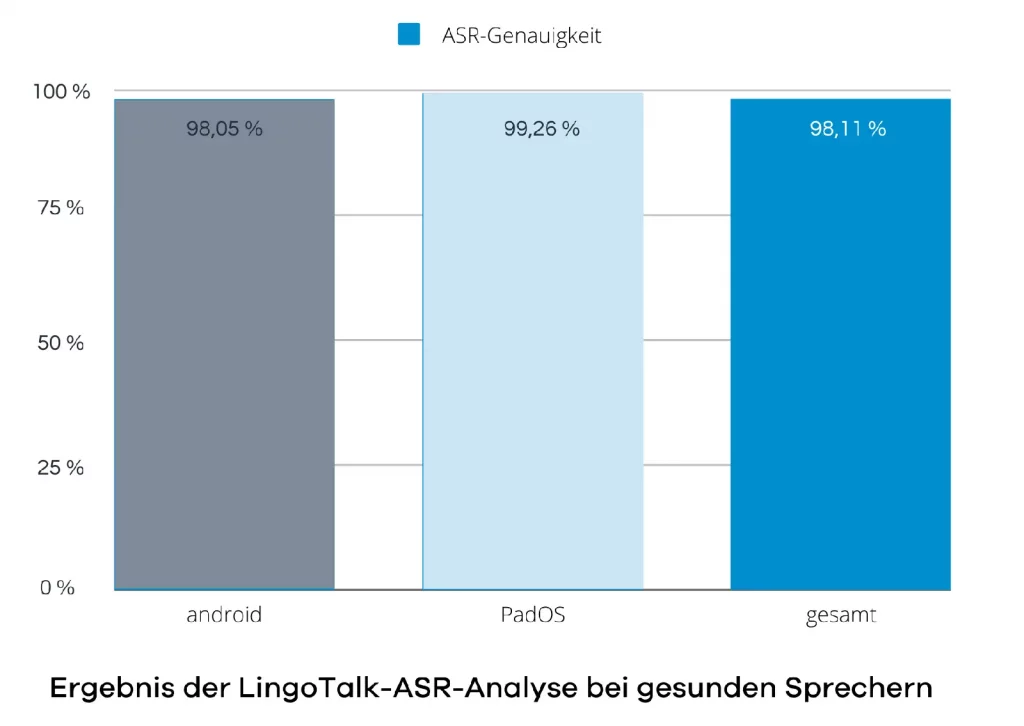

Es stellte sich heraus, dass die automatische Spracherkennung in 98,11% der Fälle funktioniert hat. Das bedeutet: Wenn das Wort richtig benannt wurde, dann hat die Spracherkennung dies auch angezeigt, und wenn das Wort fehlerhaft benannt wurde, hat die Spracherkennung das Wort abgelehnt.

Die Spracherkennung auf iPads hat dabei mit 99,26 % minimal besser abgeschnitten als bei android-basierten Geräten mit 98,05% korrekten Reaktionen.

Und bei Menschen mit Aphasie?

In Zukunft möchten wir auch an einer größeren Stichprobe von Aphasiebetroffenen die Zuverlässigkeit in Zahlen fassen. Wir erwarten allerdings keinen großen Unterschied, da es bei reinen Aphasien ja um den Wortabruf aus dem mentalen Lexikon und nicht um die Artikulationsgenauigkeit geht. Phonologische Paraphasien sollen mithilfe der App nach und nach verringert werden. Dabei helfen die drei Versuche, die jede:r Betroffene hat: so sind Selbstkorrekturen möglich. Ein Lernen findet statt.

Aus der regelmäßigen Nutzungserfahrung mit unseren Schlaganfallpatient:innen wissen wir aber jetzt schon, dass die Spracherkennung am besten funktioniert, wenn

- ausreichend laut gesprochen wird

- die Betonung natürlich und nicht überakzentuiert erfolgt und

- das Wort in Ruhe zu Ende gesprochen wird, bevor der Button losgelassen wird.

Dann klappt die Spracherkennungsfunktion auch bei schwer betroffenen Patient:innen.

Betroffene, die eine Sprechapraxie oder Dysarthrie haben, können entweder den Bewertungsmodus „Selbstbeurteilung“ wählen oder es werden gezielt Wörter ausgewählt, die die nächste Hürde beim Verständlichkeitstraining darstellen. So lassen sich Übungssets mit der professional-Version ganz individuell und störungsspezifisch zusammenstellen.

Hier ist zu sehen, wie das geht: https://www.youtube.com/watch?v=Yw4dTclaTzU